Beuaty.AI 홈페이지

Beuaty.AI 홈페이지

알파고와 같은 인공 지능에게 세계 최고의 미인을 골라보라고 했더니 백인 후보자만 선호한 결과가 나왔다.

얼굴의 대칭성과 주름들 같은 객관적 요인들을 입력한 컴퓨터 프로그램(알고리듬)이 가장 매력적인 참가자를 결정하는 첫번째 국제 미인대회에서 이런 편견이 발견됐다고 영국의 가디언이 9일 보도했다.

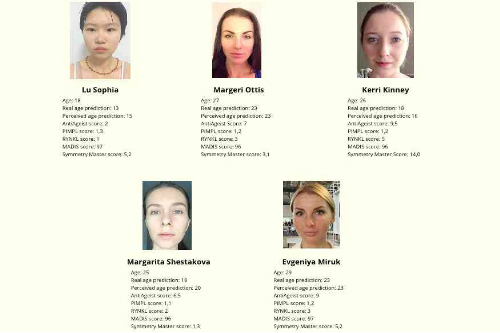

‘뷰티 닷 에이 아이(Beauty.AI)’ 가 인공지능을 활용한 국제미인대회를 지난 7월 개설한 뒤로 전세계 100개 이상의 국가에서 6,000명 가량이 자신의 사진을 보냈다. 그러나 심사 결과 승자들에게는 분명한 공통요소가 드러나 개최자들을 실망시켰다. 로봇들은 어두운 피부색, 즉 아시아계나 흑인은 좋아하지 않았던 것. 44명의 승자들 대부분이 백인이었다.

후보자 다수가 백인이기는 했지만 인도와 아프리카에서도 많은 참가자들이 사진을 보냈다. 이에 따라 어떻게 인공지능(알고리듬)이 편견에 물들어서 의도하지 않은, 그리고 종종 공격적인 결과를 산출하게 되는가에 대한 논쟁이 다시 불붙고 있다고 가디언은 전했다.

마이크로소프트가 지난 3월 선보였던 테이(Tay)라는 채팅 로봇(chatbot)은 인종차별적 용어와 신나치주의적 관점을 트위터에서 사용했다. 또 페이스북에서는 지난 달 화제의 뉴스(trending news)를 편집하는 인력들을 모두 해고하고 인공지능에 일을 맡긴 결과 허위 기사와 한 남자가 치킨 샌드위치로 자위를 하는 내용 등 낯 뜨거운 기사들이 뉴스피드에 올랐다.

알고리듬 'Beauty.AI 2.0'이 뽑은 미인들(사진=Beauty.AI 홈페이지)

알고리듬 'Beauty.AI 2.0'이 뽑은 미인들(사진=Beauty.AI 홈페이지)

이번의 인종차별적인 미인대회는 그저 조롱과 농담의 대상이 되고 있을 뿐이지만, 다른 산업과 영역들에서 편견을 가진 인공지능의 활용이 증가하고 있는 현상은 결코 웃을 일이 아니라고 컴퓨터 과학자들과 사회 정의를 추구하는 사람들은 말하고 있다고 가디언은 보도했다. 어떤 경우엔 인공지능이 유색인종과 관련된 결과를 아예 지워버릴 수도 있다.

’뷰티 닷 에이 아이’가 활용한 인공지능은 마이크로소프트가 후원하는 딥러닝(deep learning) 그룹 ‘청년실험실(Youth Laboratories)’이 만들었다. 이 인공지능은 아름다움을 판정하는 알고리듬을 만들기 위해 대량의 사진 데이터에 의존했다. 해당 알고리듬이 백인을 선호한 이유는 수없이 많지만 핵심적인 문제는 이 프로젝트가 매력의 기준을 세우기 위해 활용한 데이터가 소수자들을 포함하지 않았다는 것이라고 이 인공지능 설계팀의 책임자인 알렉스 자보론코프는 가디언에 말했다.

인공지능 설계팀은 밝은 색의 피부를 아름다움의 징표로 삼도록 입력하지 않았지만 입력된 데이터가 로봇 심사위원들을 그런 결론으로 이끌었다. 자보론코프는 승자들을 보고 놀랐다면서 “만일 유색인종을 데이터에 그리 많이 포함시키지 않는다면 편향된 결과를 얻게 된다”고 말했다. 그는 “알고리듬이 어떤 패턴을 인식하게 만든다면..데이터가 충분치 않거나 왜곡된 것이다”고 덧붙였다.

편향된 알고리듬에 대한 가장 간단한 설명은 그것을 만드는 사람이 깊이 뿌리박힌 편견을 가졌기 때문이라는 것이다. 이는 알고리듬이 중립적이고 객관적이라는 인식에도 불구하고 실제로 존재하는 편견들을 재생산하고 증폭시킨다는 뜻이다.

컴퓨터 프로그램에 의존하는 예측적 정책(predictive policing)을 연구해온 컬럼비아 대학의 버나드 하코트 교수는 이번 대회 결과가 “문제에 대한 완벽한 설명”을 제공한다고 말했다. 그는 “문화적으로 중립적이고 인종적으로 중립적인 아름다움의 개념을 찾을 수 있다는 생각이 그저 경탄스럽다”고 말했다. 이 사례는 “인간이 알고리듬에 의해 지도를 받으면서 중립적이고 과학적이라고 생각하는 순간에도 실제로는 사고를 하고 있다”는 것을 환기시켜준다고 그는 말했다.

(사진=유튜브 캡처)

(사진=유튜브 캡처)

미국의 시민단체들은 미래의 범죄를 예측하는 데이터를 사용하는 ‘컴퓨터 기반의 법 집행 예측 도구(범죄자의 재범 가능성을 판단하는 컴퓨터 프로그램들로 실제 미국 판사들과 경찰, 가석방업무 관계자들이 사용중)’들이 결점이 있는 통계에 의존하고 있으며 경찰 업무를 인종적으로 편향되고 해롭게 만들 수 있다고 최근 주장하고 있다.

“그건 정말 누군가의 생명이 위험에 빠지는 문제”라고 하버포드 대학 컴퓨터과학 학과의 소렐 프리들러 교수는 가디언에 말했다. 가장 큰 문제는 자연상태에서 소수집단은 종종 데이터에서 표현되지 않기 때문에 알고리듬이 이들에 대해 부정확한 결론에 이르고 관리자는 이를 찾아내지 않는다는 것이라고 그녀는 말했다.

편향된 인공지능 프로그램의 문제는 범죄 방지 체계에만 국한된 것은 아니다. 지난해 구글의 사진 애플리케이션은 흑인을 고릴라로 분류했다.

미국 시민단체인 미디어정의센터의 맬키아 시릴은 알고리듬이 사회적 불평등을 개선하는데 도움이 되는 한도에서 활용되도록 제한해야 한다면서 "우리는 기술과 알고리듬, 머신 러닝(machine learning)에 지나치게 의존하고 있다"고 가디언에 말했다.

‘뷰티 닷 에이 아이’의 자보론코프는 문제점을 개선해 올 가을에 다시 대회를 열 계획이지만 사실 로봇은 용모에 대한 최고의 재판관은 아니라고 밝혔다. 알고리듬은 “나라면 선택하지 않을 사람들을 뽑았다”고 그는 말했다.